北大&华科&中国移动!高功率大面积AI芯片液冷技术综述

来源 | 邹启凡1,3 刘 洪2 罗海亮2 杨荣贵1,2,3

链接 | 1华中科技大学能源与动力工程学院 武汉 430074;2中国移动通信集团设计院有限公司 北京 100080; 3 北京大学力学与工程科学学院能源与资源工程系 北京 100871)

摘要:随着人工智能(artificial intelligence, AI)技术的升级迭代,巨大的算力需求推动了AI芯片的发展,特别是近年来 开发的芯粒(Chiplet)技术,为人工智能提供了高计算性能、高良品率、低成本的先进芯片封装集成方案,为AI发展提供 了坚实的硬件支撑。Chiplet型芯片具有大面积、高发热功率的特征,其3D的芯片堆叠设计带来了热流分布不均匀、多层芯 片导热路径长、填充热界面材料较厚等散热难题,成为了芯片性能提升的关键瓶颈,Chiplet 型芯片的高效热管理成了人工 智能发展的关键挑战。本文综述了芯片热管理的先进液冷技术进展,包括单相与两相液冷方案,基于冷却架构分为冷板式液 冷、近结区液冷与浸没式液冷,并针对2.5D、3D Chiplet 型芯片中的散热问题与冷却方案进行了总结,为高功率大面积AI 芯片的液冷方案的应用与发展提供参考。

关键词:人工智能;Chiplet技术;芯片热管理;单相液冷;两相液冷

01

背景

人工智能(artificial intelligence,AI),凭借其对人类智能的模拟与拓展,赋能计算机执行各类复 杂任务,在移动终端、无人驾驶、智能家居、工业 物联网、工程科学和智慧医疗等广阔的生产、生活与认知领域发挥着重要作用,是当今推动科技创新 和社会进步的重要力量。AI技术的创新与普及依 赖于AI芯片的快速发展。AI芯片具备高并行度和高计算效率的显著特性,通过定制化的硬件加速 组件,诸如张量核心(Tensor Cores)、神经网络处理单元(neural processing unit,NPU)等,支撑起复杂任务带来的巨大计算需求,在提高计算效率、 降低能耗和提升性能方面具有显著优势,是实现AI 技术商业化的核心基石。随着半导体芯片制程迈向2 nm甚至更小,芯粒(Chiplet)三维架构型的AI芯片尺寸和功耗不断增加,发热特性呈现出大面积、 传统数据中心通过风冷散热,由于空气的导热系数 高功耗、高热流且分布不均匀和热负荷动态变化大 等特点,对传统热管理方案的能耗与温控性能提出 了巨大的挑战。图1所示为芯片发展带来的节能减排问题。

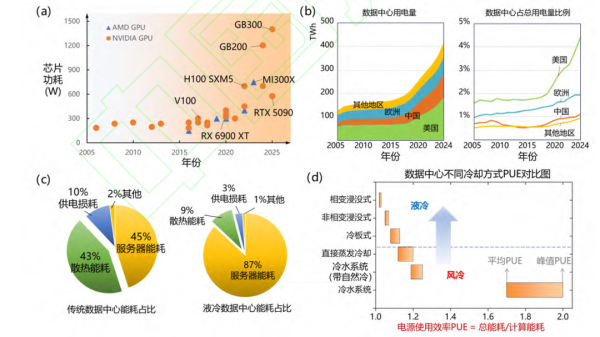

图1 芯片发展带来的节能减排问题(a)芯片功耗随年份增长统计;(b)世界各地区数据中心用电量增长与数据中心用电占比 (c)数据中心中能耗占比 ;(d)不同冷却方案的PUE对比。

液冷数据中心通过利用液体的高导热系数进行,有效地将散热能耗占比降至9%。随着冷却技术 逐步从风冷、自然冷发展到新型液冷的过程中,其能源利用效率PUE(power usage effectiveness,通常定义PUE=数据中心总能耗/服务器设备能耗)从 2 逐步降至1.1以下,如图1(d)所示。在液冷散热技术中目前已经落地示范的包括冷板式、非相变浸没式、相变浸没式液冷,其中冷板式液冷与芯片封装、现有风冷架构均具备良好兼容性,能基于现有数据中心改造,甚至可以实现复合风冷、液冷的风液融合散热方案。浸没式液冷能实现更低的 PUE,其与现有的芯片封装能良好兼容,但需要使用浸没式服务器机架,多用于新建的数据中心。此外,为了进一步提升冷却性能、降低PUE,基于芯片封装层面开发的近结区冷却方案也存在许多研究,为新一代冷却方案提供了可能。

图2 芯片面临的高热流密度热管理挑战

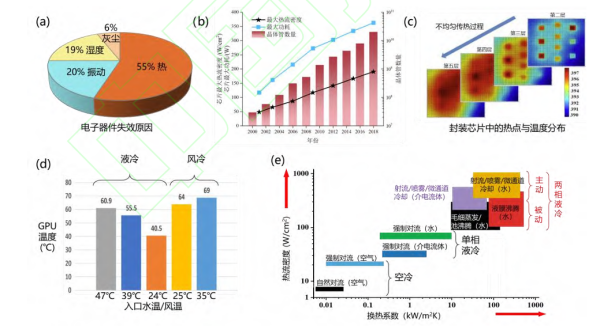

(a)电子器件失效原因占比;(b)芯片晶体管数量增长[10]和最大热流统计 (c)封装芯片中的热点与温度分布 ;(d)风冷和液冷方案下的GPU芯片温度对比 (e)不同冷却方式的热流密度、传热系数的对比(传热性能数据基于文献中1 cm×1 cm以上热源面积)

芯片的发展不仅引起了能耗问题,还带来了对芯片温度控制的热管理挑战,统计结果表明55%的电子产品是由于热问题失效,如图 2(a)所示。随 着半导体工艺的发展,图2(b)所示为芯片中晶体管的数量以指数级增长,芯片中的最大热流密度超过 100 W/cm2。芯片的最高工作温度约为 85~95 ℃,如NVIDIA H100 PCIe 中图形处理单元 (graphics processing unit,GPU)的最高工作温度 为87 ℃、高带宽内存(high bandwidth memory, HBM) 的最高工作温度为95 ℃。如图2(c)所示,封装芯片中的发热呈现不均匀特征,为了有效控制局部热点温度,需要采用换热性能更好的冷却方案以防止热失效。风冷难以对小空间内的大量芯片实现高效冷却,在单芯片功率为300~400 W时逐渐过渡为液冷方案。液冷相比风冷具有更高的换热性能, 这是由于液体的导热系数和热容远大于空气,如水 的导热系数约为0.59 W/(m⋅K),比空气的导热系数 0.026 W/(m⋅K)大一个数量级。风冷和液冷对芯片的 冷却效果如图2(d)所示,在 25 ℃的入口风温时, GPU 温度为 64 ℃,比入口温度相近的液冷高约 23.5 ℃。不同冷却方式的临界热流密度(critical heat flux, CHF)、传热系数(heat transfer coefficient, HTC) 对比如图2(e)所示,根据热流密度、传热系数可以表征液冷方案的散热性能,如加热面的过热度ΔT=热流密度 q/传热系数 h,进而根据流体温度可 以确认芯片温升是否在安全范围内。

02

芯片液冷系统及架构

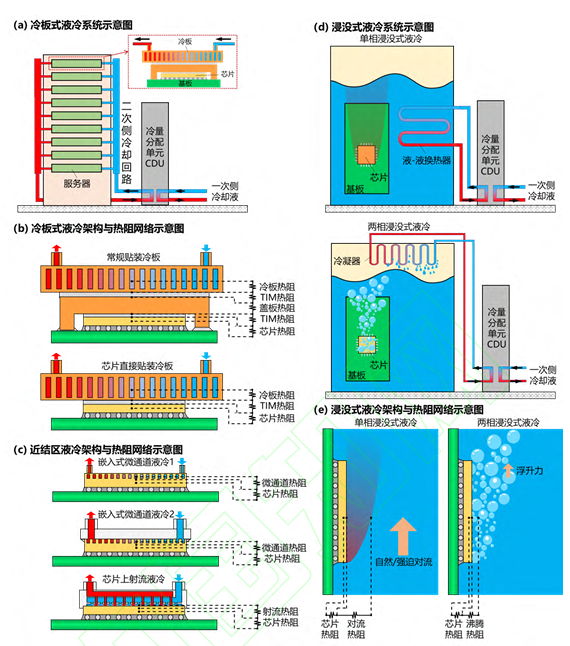

液冷技术通过液体工质将热量高效地从芯片带走,再与环境进行换热,最终将芯片产热排至环境中。其中液体工质与封装芯片的传热方案设计是实现高性能芯片液冷技术的核心内容,目前较为成熟的液冷技术主要包括冷板式液冷与浸没式液冷。 随着液体侧强化传热方案的进步,芯片封装的导热热阻占比不断增大,芯片液冷架构呈现从传统冷板式液冷的远端冷却向近结区冷却发展的趋势。

图3 目前发展的液冷方案a)冷板式液冷系统 (b)冷板式液冷架构与热阻网络;(c)近结区液冷架构与热阻网络 (d)浸没式液冷系统;(e)浸没式液冷架构与热阻网络

03

图文导读

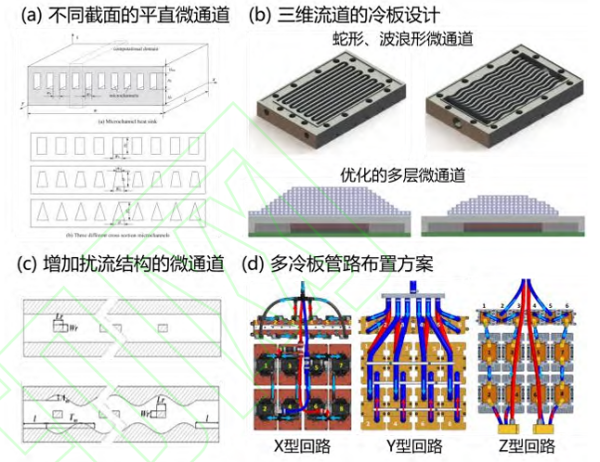

图4 单相液冷板设计方案

(a)不同截面的平直微通道 (b)三维流道冷板,如蛇形、波浪形微通道、优化的多层 微通道 (c)加扰流结构的微通道 (d)多冷板管路布置方案

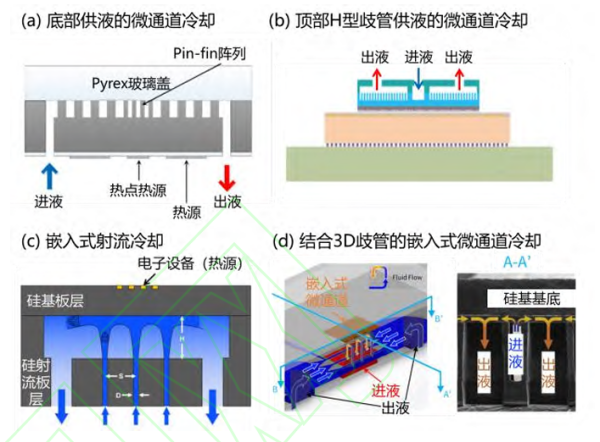

图5 近结区单相液冷方案

(a)底部供液的嵌入式微通道冷却 (b)顶部H型歧管供液的嵌入式微通道冷却 (c)嵌入式射流冷却 (d)结合3D歧管的嵌入式微通道冷却

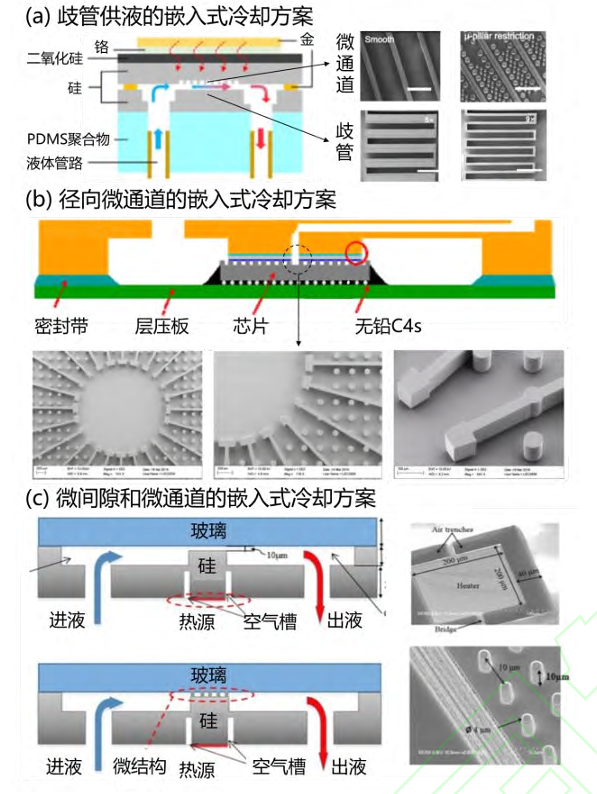

图6近结区两相液冷

(a)歧管供液的嵌入式冷却方案 (b)径向微通道的嵌入式冷却方案 (c)微间隙和微通道的嵌入式冷却方案

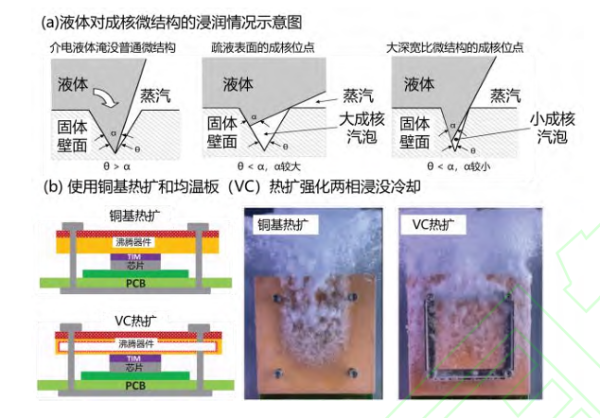

图7 两相浸没式冷却技术

(a)液体对成核微结构的浸润情况示意图 (b)使用铜基热扩和均温板(VC)热扩强化两相浸没冷却

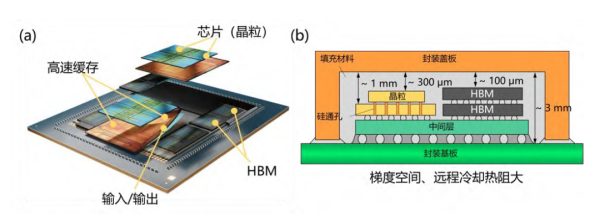

图8 Chiplet 型芯片架构

(a)多热源分布示意图 (b)阶梯空间中的厚度不匹配示意图

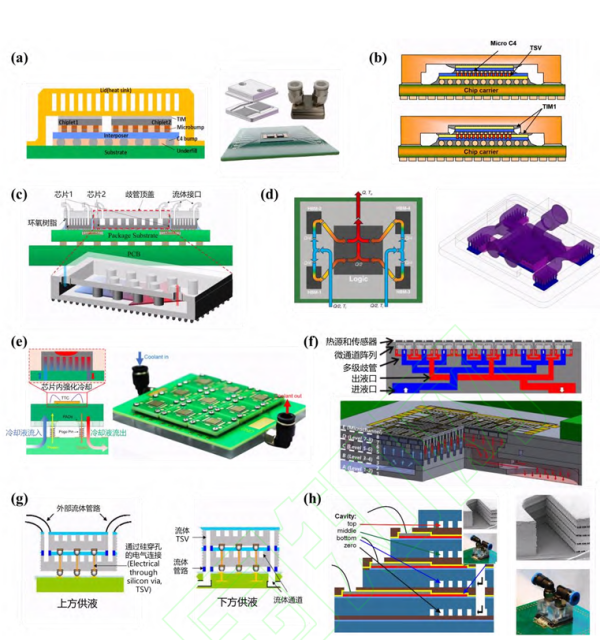

图9 Chiplet 型芯片强化冷却方案。

(a)对 2.5D Chiplet 型芯片直接使用冷板式液冷散热 (b)通过定制封装盖板(Lid)强化Chiplet型芯片散热性能 (c)在 2.5D Chiplet 型芯片上表面通过嵌入式微通道液冷散热(d)在 2.5D Chiplet 型芯片上表面通过射流冷却散热 (e)在 2.5D Chiplet 型芯片下方通过嵌入式微流道冷却,在PCB中制备可配置、替换供液冷却单元回路的方案(f)在 2.5D Chiplet 型芯片下方通过紧凑微通道液冷器件冷却(g)在 3D 堆叠芯片中上方、下方供液的嵌入式微通道冷却方案(h)在 3D 堆叠芯片实现中间供液的嵌入式微通道冷却方案。