Phononic发布固态制冷方案,助力AI数据中心散热

来源 | TMT通讯社

[洞见热管理]获悉,近日固态冷却技术全球领导者Phononic正式发布面向人工智能数据中心的智能冷却解决方案。该方案通过精准热管理技术释放AI硬件性能潜力,同时显著优化基础设施投资回报,为应对AI工作负载激增带来的散热难题提供了突破性路径。

01

热电技术赋能 毫秒级冷却

“AI芯片的热约束已成为算力释放的关键障碍,尤其是高带宽内存(HBM)堆栈的底层芯片极易因热量堆积触发节流机制,导致硬件无法发挥全部潜力。”Phononic首席产品官Larry Yang指出,这种性能损耗最终会转化为额外的GPU采购成本,加剧企业负担。

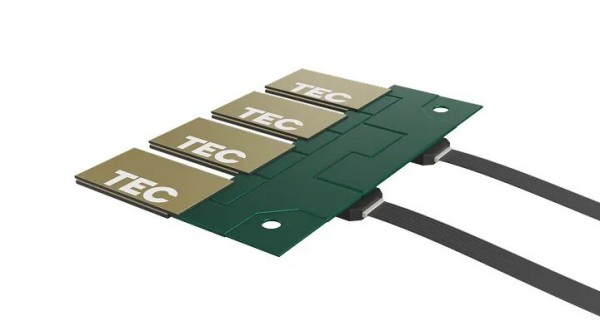

Phononic此次推出的“散热套件”(Thermal Kit)以公司成熟的高性能热电冷却器(TEC)为核心,集成机械与热架构模块,并通过API可访问的控制固件与软件实现全链路协同。该方案从xPU芯片与HBM内存等核心组件入手,可与现有液冷系统无缝集成,实现芯片级热点的快速温控。

与传统冷却系统的慢响应特性不同,这套解决方案依托热电效应原理,能在几毫秒内完成温度调整,在组件级别主动管理热量。其TEC组件采用“华夫饼”式陶瓷冷板结构,将热电材料切割为1毫米立方体精准覆盖热源,已通过3000万片的量产验证,作为NVIDIA 1.6T光学收发器的独家热电供应商,技术可靠性备受行业认可。

“散热套件旨在直击AI数据中心的核心冷却痛点。”Phononic基础设施解决方案高级副总裁兼总经理Matt Langman强调,对于面临空前电力需求的AI运营商而言,通过减少热节流并优化液冷设施能耗来维持性能至关重要,“这一突破能帮助客户释放更高计算能力,在全数据中心范围内实现可观的投资回报”。

02

四维价值突破

实测数据显示,该冷却方案通过四大核心优势构建价值闭环,使AI数据中心的投资回报周期缩短至个位数月。在性能提升方面,其精准温控可显著减少GPU热节流现象,使Transformer模型训练、LLM推理等内存密集型任务效率大幅提升,且无需芯片制造商重新设计硬件;在资产利用上,通过稳定性能输出,超大规模企业无需重建基础设施即可提升现有硬件容量;温度的一致性控制还能减轻核心组件损耗,延长高价值AI设备寿命;而将二次冷却回路温度提升数度的设计,可降低冷水机负载,减少整体能源消耗。

值得关注的是,该方案还具备软件定义的智能特性。其“热织物”编排软件通过Redfish API标准实现遥测与控制,可根据工作负载需求动态切换“涡轮模式”(高速推理)与“经济模式”(能效训练),在不同场景下实现性能与能耗的最优平衡。Phononic更已申请专利,将热电材料直接附着于硅片,进一步简化集成流程以适配未来更高热密度的芯片设计。

03

关于Phononic

Phononic公司专注于创新半导体冷却解决方案,以可持续方式重塑冷却技术应用格局。其热电芯片及集成产品在数据中心、光通信等关键领域发挥核心作用,为AI算力基础设施提供精确、可预测的热管理支持。依托实时热响应技术,Phononic助力客户加速投资回报周期,实现更快的AI洞察生成。

03

总结

凭借在冷却技术领域的深厚积累,Phononic的解决方案已在光收发器冷却领域实现全球大规模部署,赢得一级超大规模企业与领先OEM厂商的信赖。其无制冷剂的固态技术路径,更契合数据中心可持续发展需求,为减少制冷相关排放提供了环保选择。

第六届热管理产业大会暨博览会作为热管理领域的顶尖盛会,大会汇聚了产业链上下游企业、科研机构及终端应用方,能为企业搭建技术展示、供需对接与行业交流的核心平台。诚挚邀请产业链同仁出席交流。

展会时间:2025年12月3-5日

展会地点:深圳国际会展中心