别只盯着芯片:数据中心液冷是一门系统工程

上一期我们聊的主题是:数据中心热得发烫?问题出在芯片这头

文章里提到芯片在燃烧,散热却“两拨人、两种语言”,结果就是高性能AI芯片产热节节攀升,而系统级的冷却接力却未必能跟上节奏。

那芯片的“热浪”到底去了哪?

热从硅片出发,穿过封装基板、热界面材料,再被冷板带走;

沿着管路奔向系统级的换热器……热量的“出逃路线”,其实是一条复杂又高耦合的链路;

从封装、冷板,到液路、电源、服务器结构乃至整机换热模块;

每一步如果设计脱节,最终都会在能耗、可靠性、系统性能上反噬而归;

所以问题来了:我们是否也该用“系统工程”的思维,来重新审视热管理?

00

AI数据中心热管理不能只盯着芯片

上篇文章发出后,大家反响热烈,纷纷认同芯片级热管理的复杂性,也提出不少新观点。但一个关键问题逐渐浮现:

当芯片的高热流成功被“接住”后,这些热量接下来到底该去哪儿?

芯片层的热管理固然重要,但它只是数据中心散热链条上的第一环。真正的挑战是如何将这股热流有序、高效地传递出去,最终带走。

这正是整机及系统级热设计的核心难题:如何围绕服务器机箱、整机液冷系统,乃至整个数据中心,构建一套科学、精准且经济的热管理体系?

换句话说,热管理不能只盯着芯片,还得看芯片“外”的世界。

接下来的内容,我们将聚焦系统级的液冷方案,探讨它们如何承接芯片的“热浪”,以及面临的技术挑战和创新路径。

01

全链路热管理

在高功率AI服务器逐渐突破1kW大关的今天,风冷已经不堪重负。于是,整机级液冷正被越来越多数据中心“从选配变标配”。在这条路径上,几种典型液冷方案(冷板、浸没、喷淋)陆续成熟。这些方案背后,冷板流道设计、冷却液材料、电气绝缘安全、分布式泵浦系统的协同,构成了一个完整的“热管理生态”。

你看到的每一个冷板背后,其实都是一次整机系统重构。从芯片 → 封装 → 冷板 → 歧管 → 分布式泵 → 机柜级换热器 → 机房水冷系统,当芯片热量释放出来,仅仅“从芯片上带走”并不代表散热完成。真正的液冷热设计,是一个从纳米级热源到整机级散热的完整热路径协同。

可以将整个系统看成一个串联的热流通道,每一级既是“传热节点”,也是“热阻瓶颈”。

1. 芯片与封装(Chip & Package)

作用:局部高热通量的直接来源;芯片常出现热点集中、冷热不均。

材料关注点:高导热TIM(硅脂、焊料、液态金属);先进封装(2.5D、Chiplet)带来热路径新挑战。

2. 冷板(Cold Plate)

作用:芯片级热量的第一站“接收器”;设计决定是否能精准接热。

设计重点:微通道结构布局是否与芯片热点匹配?流道形状(直通/蛇形/喷淋)与压降、换热效率的平衡;材料导热性(铜、铝、不锈钢)与冷却液腐蚀性的匹配。

3. 歧管(Manifold)

作用:将机架内多个冷却液流路集中管理与分发。

关键点:分支流量控制精度;接口标准化程度(ODCC、OCP标准);快插快拆设计能否降低维护成本。

4. 分布式泵(Pump)

作用:确保液冷系统稳定、可控的循环压力与流量。

设计难点:噪声与震动控制;长期稳定性与冗余;冷却液类型决定泵的选型(对醚类/氟液兼容性)。

5. 机柜级换热器(Rear Door Heat Exchanger / CDU)

作用:将液冷系统携带的热量释放到外部环境。

常见形式:后门换热器(RDHx,水-空气换热);机架冷却分配单元(CDU,水-水换热,连接外部冷却水)。

关注点:冷凝水管理与防滴漏;热交换效率与系统能耗比(PUE)优化。

6. 机房水冷系统(Facility Cooling Loop)

作用:最终热量排出通道,通常通过楼宇冷却塔、水冷机组完成。

协同点:与IT负载的动态热负荷联动;接入楼宇自动系统(BAS)实现智能调度。

02

液冷服务器热管理方案类型

(1)冷板式液冷

冷板式液冷是目前数据中心服务器热管理中最成熟、应用最广泛的液冷技术。其核心是在服务器芯片及关键热源部位安装冷板,通过内部微通道循环冷却液,将热量高效传导出去。冷板多采用铜、铝等高导热金属,流道设计丰富,确保精准高效的热交换。

优势与挑战:冷板液冷广泛应用于高性能计算(HPC)、AI服务器,显著降低芯片温度,提升性能稳定性,同时减少风机功耗,优化数据中心PUE。挑战在于热界面材料(TIM)的导热与机械兼容性、冷却液流道堵塞与腐蚀风险,以及系统集成中对泄漏的严格控制。

(2)浸没式液冷

浸没式液冷(Immersion Cooling)指的是将整个服务器或者电子组件浸没在绝缘冷却液中,通过液体直接带走热量的散热方式。冷却液通常选用高绝缘性、化学稳定性好的液体,如氟化液(Fluorinert)、矿物油或合成油。这种方式绕过了传统风冷或冷板,冷却液直接接触热源表面,实现高效热交换,同时避免了传统风冷中风扇噪音和空气热阻。

优势与挑战:极高的冷却效率,能够应对超高功率密度的热源;降低风扇能耗及维护复杂度,减少噪音和灰尘影响;设计灵活,可应用于整机甚至机架级浸没。挑战在于绝缘液的成本较高(目前业内已经解决液体的成本问题),且对材料兼容性有较高要求;维护检修复杂,需要专门工艺与设备支持;液体泄漏风险和环境安全需严格管控。

(3)喷淋式液冷

喷淋式液冷(Spray Cooling)通过将冷却液以细小液滴的形式直接喷射到服务器芯片或热源表面,实现高效的传热和散热。液滴迅速蒸发或吸收热量后被回收循环使用。这种方法相较于传统冷板和浸没式液冷,能够更精准地针对热点位置进行冷却,且液体用量较少,减少系统复杂度。

优势与挑战:热交换效率高,能应对极端局部高热流密度;液体直接喷洒于热源,冷却更直接更迅速;系统设计相对灵活,便于热点针对性处理。挑战在于喷淋系统设计复杂,需要精密喷头和流量控制;液滴分布均匀性影响散热效果,要求高工艺水平;液体蒸发与回收系统需稳定可靠,防止泄漏和腐蚀。

03

整机液冷的设计难点

1. 热源分布与液路匹配

在高密度服务器中,热源的分布呈现出高度非均匀性,尤其是在AI加速卡、GPU和CPU等组件上。传统的冷板设计往往难以精确匹配这些热点区域,导致冷却效率降低。因此,液冷系统的流道设计需要根据热源的具体位置进行优化,以实现更高效的热传导。

2. 高密度集成下的可靠性设计

随着功率密度的增加,液冷系统面临更高的可靠性要求。潜在的泄漏、腐蚀、清洗和维修等问题成为系统设计中的关键挑战。例如,冷却液的选择需要考虑其对材料的腐蚀性,系统的密封性需要确保长期运行中的稳定性。此外,液冷系统的清洗和维护也需要简化,以降低运维成本。

3. 冷却液材料选择

冷却液的选择直接影响系统的热性能和长期稳定性。常见的冷却液包括聚乙二醇水溶液(PG/WG)、氟化液和醚类液体等。每种冷却液都有其独特的热物性和化学稳定性,需根据具体应用场景进行选择。例如,氟化液具有良好的电气绝缘性,适用于对电气安全要求高的场景;而醚类液体则在热传导性能上表现优异,适用于高功率密度的应用。

4. 整机EMC、电气安全与维护接口设计

液冷系统的设计不仅要满足热管理需求,还需考虑电磁兼容性(EMC)和电气安全性。液冷系统中的冷却液可能对电子组件产生影响,因此需要采取措施确保系统的电气安全性。此外,液冷系统的维护接口设计也至关重要,需确保在系统运行过程中能够方便地进行检查和维护,以降低运维成本。

04

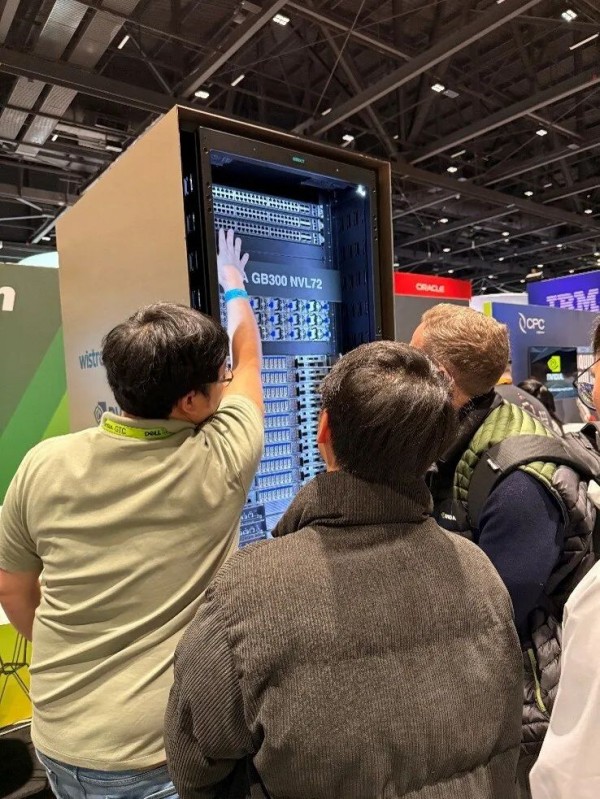

GB300 NVL72最新动态

随着人工智能模型参数量和推理训练规模的不断扩大,AI算力平台正在经历一场前所未有的跃迁。2024年,NVIDIA推出的GB200 Grace Blackwell超级芯片架构,已在NVL72整机形态中实现部署。

2025年GTC大会,GB300平台的问世再次将单机性能推至新高。其内部包括72颗Blackwell GPU + 36颗Grace CPU组成18个 Grace Blackwell Superchips;所有GPU之间通过NVLink Switch System互联,提供前所未有的低延迟高带宽;GB300平台整机热设计功耗(TDP)突破1.2kW,GB200为1kW。单卡功耗提升,GB300 NVL72整个机柜的能耗仍保持在132kW,传统风冷方案几乎无法满足散热需求;全面采用Direct-to-Chip冷板液冷系统。

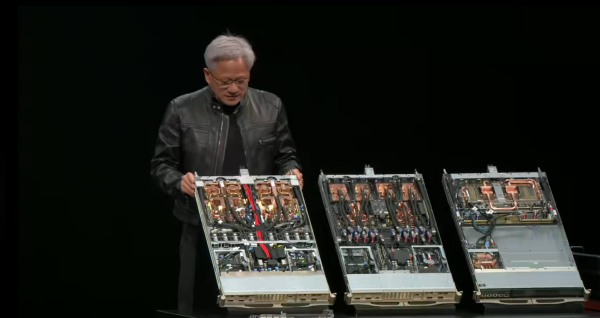

近日2025年台北国际电脑展(Computex 2025)在中国台北拉开帷幕,英伟达首席执行官黄仁勋在展会开幕式发表的官方主题演讲成为全球关注焦点。周一上午11点,“皮衣黄”准时登台并进行了超过100分钟的演讲,发布了一系列英伟达公司在软硬件方面的更新。值得一提的是,黄仁勋第一次在演讲中公布如此详细的GB300 NV72的制造流程以及部分合作伙伴。

黄仁勋表示Grace Blackwell已全面投入生产,并于2月开始交付。英伟达将于今年第三季度推出GB300硬件系统,据介绍GB300配备了升级版Blackwell芯片,其推理性能提升了1.5倍,HBM内存容量增加了1.5倍,网络连接能力翻倍,整体性能都得到加强。

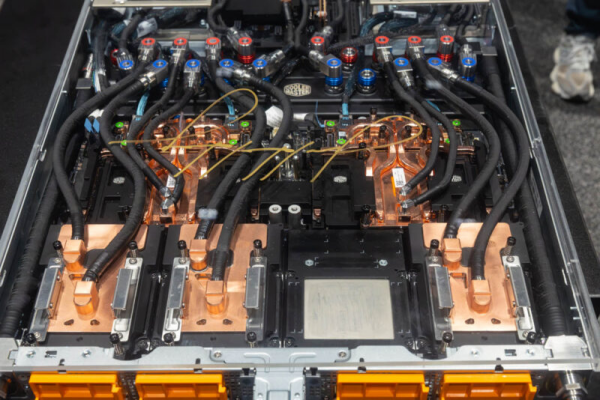

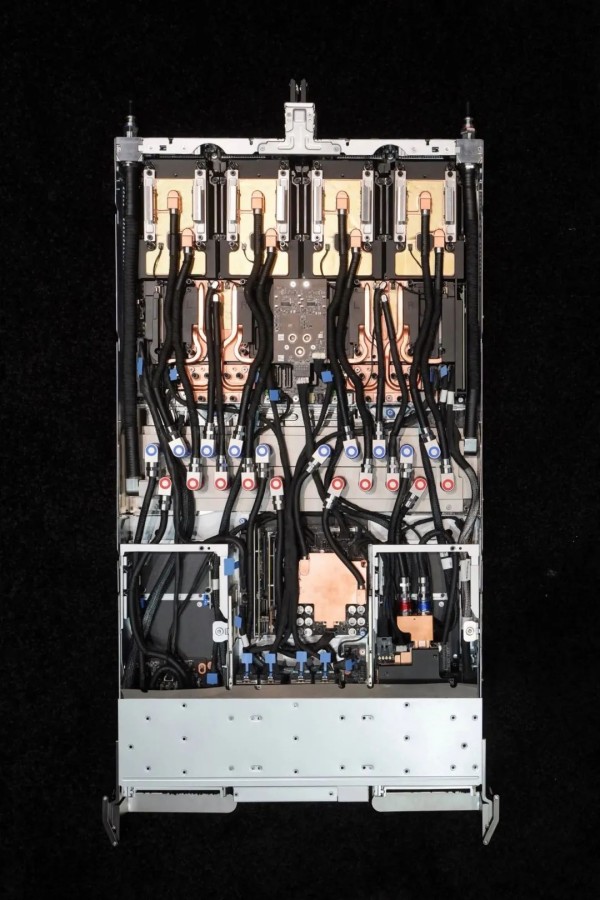

演讲中展示了样机,图中从左至右分别是GB200、GB300和NVlink Switch,均采用100%液冷散热。可以注意到GB300的主要变化集中在内部冷板(coldplate)的设计上,GB300采用了独立液冷板设计,每个芯片配备单独的一进一出液冷板,而非大面积冷板覆盖方式。采用单独的小冷板设计,将快接头的使用量增加了约一倍。

GB200每个computetray包含两个大冷板,每块需要两对(进、出)快接头,共计四对。此外,computetray通过manifold向外连接时,还需额外增加两对。因此,一个GB200computetray总计需要六对快接头。因此对于NVL72系统18个computetray需要108对快接头。

GB300采用了独立液冷板设计,每个芯片配备单独的一进一出液冷板。NVL72系统中,一个computetray包含6个芯片,共12对快接头。如果加上manifold接口则总数为14对,因此NVL72系统中需要252对快接头。

其他组件如manifold、CDU以及cartridge等均沿用GB200的原有设计,无需额外调整。

05

GB300 NVL72的整机液冷实践方案解析

液冷的普及,已经从某个厂商的“高端选配”转变为整个AI整机系统设计的基础条件。从GB200开始,NVIDIA就已将液冷冷板、分配管路与GPU主板结构进行深度耦合;而到了GB300阶段,液冷已经全面融入电源、电池备份、冷却控制器等多个子系统之中,真正进入“整机级液冷协同设计”时代。与此同时,AI整机液冷不再只是NVIDIA一家主导,而是形成了以NVIDIA为核心、多厂商生态响应的新格局。今年2025GTC大会上Foxconn、Supermicro、ASUS、和硕等多家厂商同步推出了支持GB300 NVL72新一代液冷整机产品,反映出液冷技术正在从“技术选项”走向“生态基础设施”。

以下是几种典型的整机液冷实践案例,展示了不同液冷方案在实际应用中的表现:

(1)英伟达GB300 NVL72

GB300 NVL72这是一套融合了液冷、模块化系统设计和AI算力资源池化的完整机架级解决方案。它不仅代表着AI芯片的新高度,也标志着整机液冷技术正式走进主流部署舞台。整个液冷系统分为几个关键环节:

英伟达NVL72方案部署在单机架内,搭载了:

18台计算服务器(18 Compute Nodes)

72个Blackwell Ultra GPU + 36个Grace CPU组成的模块化系统

使用 GIGABYTE 服务器与 Chenbro 机架

冷却容量高达135kW,由Delta CDU提供液冷回路支持

这体现了NVL72方案的三个关键特征:高功耗密度、高热通量、模块化液冷支持

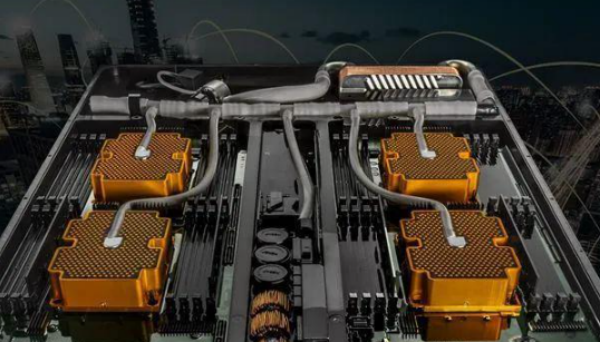

整机中液冷冷板与液路连接,每个计算节点内部GPU与CPU均部署定制化液冷冷板,可见铜制冷板覆盖多个芯片区域;接头数量密集说明至少GPU、CPU等高发热元件均有独立散热回路;推测采用串并混合式液路,以在保证温升控制的同时优化压降。

使用红蓝标识区分冷热流(inlet/outlet),接口为标准快接;管线采用预制波纹管+快速插拔接头组合,方便维护与更换;接头后设有分支控制模块(可能为分流/汇流组件或控制阀)。GPU区的液冷板和管线设计保持统一标准,说明具备高扩展性;整体液路系统嵌于机架前半段,便于热交换效率最大化;电控、供电与液冷回路明显分区隔离布局,降低电气风险。

(2)Supermicro GB300 NVL72

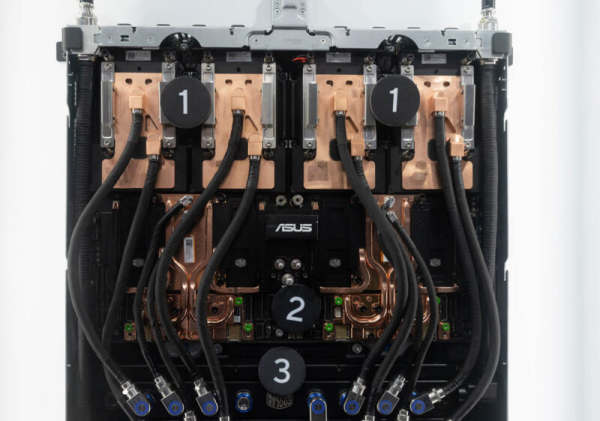

Supermicro推出搭载NVIDIA Blackwell Ultra平台新系统和机架解决方案,将NVIDIA Blackwell Ultra整合至两种解决方案:适用于各种数据中心的 Supermicro NVIDIA HGX B300 NVL16系统,以及具有新一代NVIDIA Grace Blackwell架构的NVIDIA GB300 NVL72(如下图所示)。

Supermicro透过液冷散热、数据中心部署和建构组件技术的专业优势,以领先业界的部署速度提供NVIDIA Blackwell Ultra。Supermicro也具有完整的液冷产品组合,包括新开发的直达芯片液冷板、250kW机架内建式冷却液分配单元,以及冷却水塔。

(3)华硕GB300 NVL72

(4)和硕GB300 NVL72

(5)纬颖Wiwynn GB300 NVL72

(6)富士康GB300 NVL72

作为GB300 NVL72平台的PBR(Pilot BuildRequest)供应商,富士康协助相关产品的设计与制造,致力于确保运算效能最佳。这套先进的超级芯片生态系统,基于NVIDIA Blackwe11架构,并结合集团鸿佰子公司设计制造的液冷技术,通过NVIDIA Omniverse 数字孪生技术优化服务器散热与数据中心设计,确保高效且稳定的运行环境。

系统集成的背后不仅仅是“上水”,而是“重构服务器”,NVIDIA的设计强调:“液冷不是加一个冷板,而是重构一整台服务器。”整机采用横插式模块,实现热插拔冷板单元;液冷通道与NVLink互联结构相互配合,物理布局为热交换与信号完整性协同优化;在整机热预算控制下,实现了比H100 DGX系统更高的能效比。

液冷走向“整机定义”而非“附加模块”,GB300 NVL72给整个产业带来的信号很明确:热管理不再是末端工程,而是系统级产品定义的起点。这也是从“芯片热设计”走向“平台级热定义”的一次转变。

06

关键问题探讨

在整机液冷系统的设计与应用中,以下问题值得深入讨论:

(1)是否所有整机都适合采用液冷技术?

液冷技术虽然在高功率密度场景中表现优异,但其成本和复杂性较高。因此,是否采用液冷技术需要根据具体的应用场景和需求进行评估。

(2)如何实现液冷系统与服务器结构、电气系统的解耦?

液冷系统的设计需要与服务器的结构和电气系统进行协同,以确保系统的整体性能。然而,过度的耦合可能导致系统的复杂性增加,因此需要在设计中实现适当的解耦。

(3)未来液冷服务器是否需要从结构层级彻底重构?

随着液冷技术的发展,未来的服务器可能需要从结构层级进行彻底的重构,以更好地适应液冷系统的需求。这包括冷却液的流道设计、冷却板的布局以及维护接口的设置等方面。

从技术协同,到产业协同——我们需要一个共同思考的舞台

整机液冷的挑战,不只是技术细节的堆叠,更是系统工程的协同考验

从芯片到冷板,从分布式泵到换热器,每一环都牵一发而动全身

而液冷真正的落地,也不仅是某一类产品的迭代,而是数据中心设计逻辑的整体重塑

我们正在见证一个新热管理时代的开启

而产业上下游,也亟需一次更系统、更深入的对话